使用 AI 优化界面交互

最近在跟小伙伴们探索如何写一个好剧本,我们作为非专业人士,对于好的剧本可能缺乏一定的认知,我们就在想是不是可以让 AI 告诉我们什么是好剧本,但这是一个比较主观的东西,一千个读者就有一千个哈姆雷特。

那有什么比较客观的测量方法吗?像我大学修的教育学和管理学,我们教育学领域就有教学测量学这么一个东西,包含各种模型量表,去测评教案教学方式是否达标,管理学和经济学领域也都有相应的模型和工具去测评。那么剧本应该也是有的,我们想到是不是可以利用剧评去给剧本打分,分值高的我们就认为他是一个好剧本,就像我们要去看一部电影前,可能回去看豆瓣评分,这是一个比较大众化的评分,表达了大多数人的观感。

评论一个好剧本可以用剧评去给剧本打分,那么 UI 界面是不是也可以用这套测量呢?查了一下,UI/UX 领域有一些评估模型,比如SUS (系统可用性量表)、PUEU (感知有用性与易用性) 以及 HEART 模型(产品健康度模型)等,我们可以让 AI 根据这些模型对我们设计做优化,比如这样

[file] |

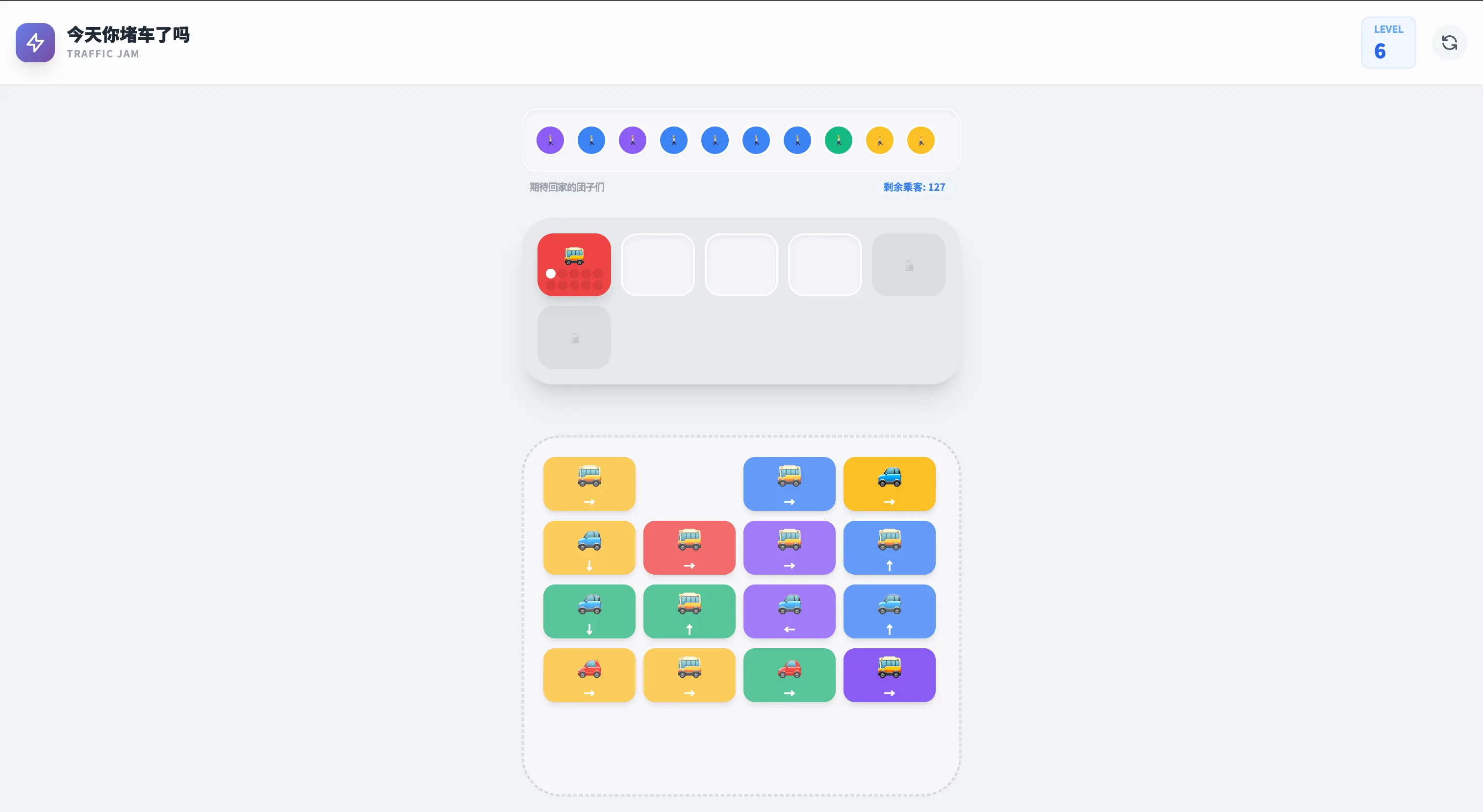

下面是我做的一个实验,我有一个现成的小游戏,他长这样

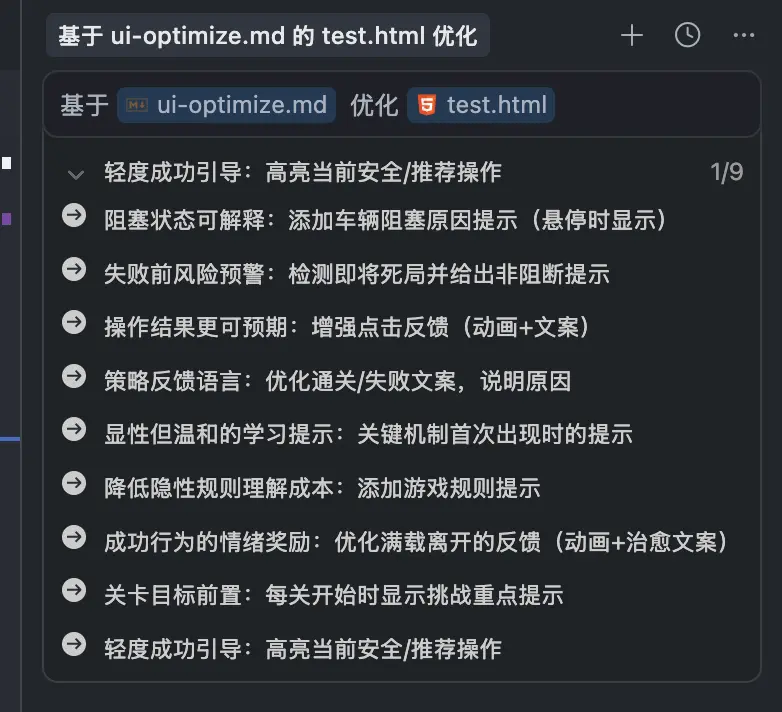

利用上面的提示词,让 chapgpt 对游戏界面和交互做一些优化,AI 给出了一些建议:

下面是**基于 SUS、PUEU 与 HEART 模型的 UI/UX 改进点精炼总结**,适合直接放进**产品文档 / 设计评审 / 迭代清单**中。 |

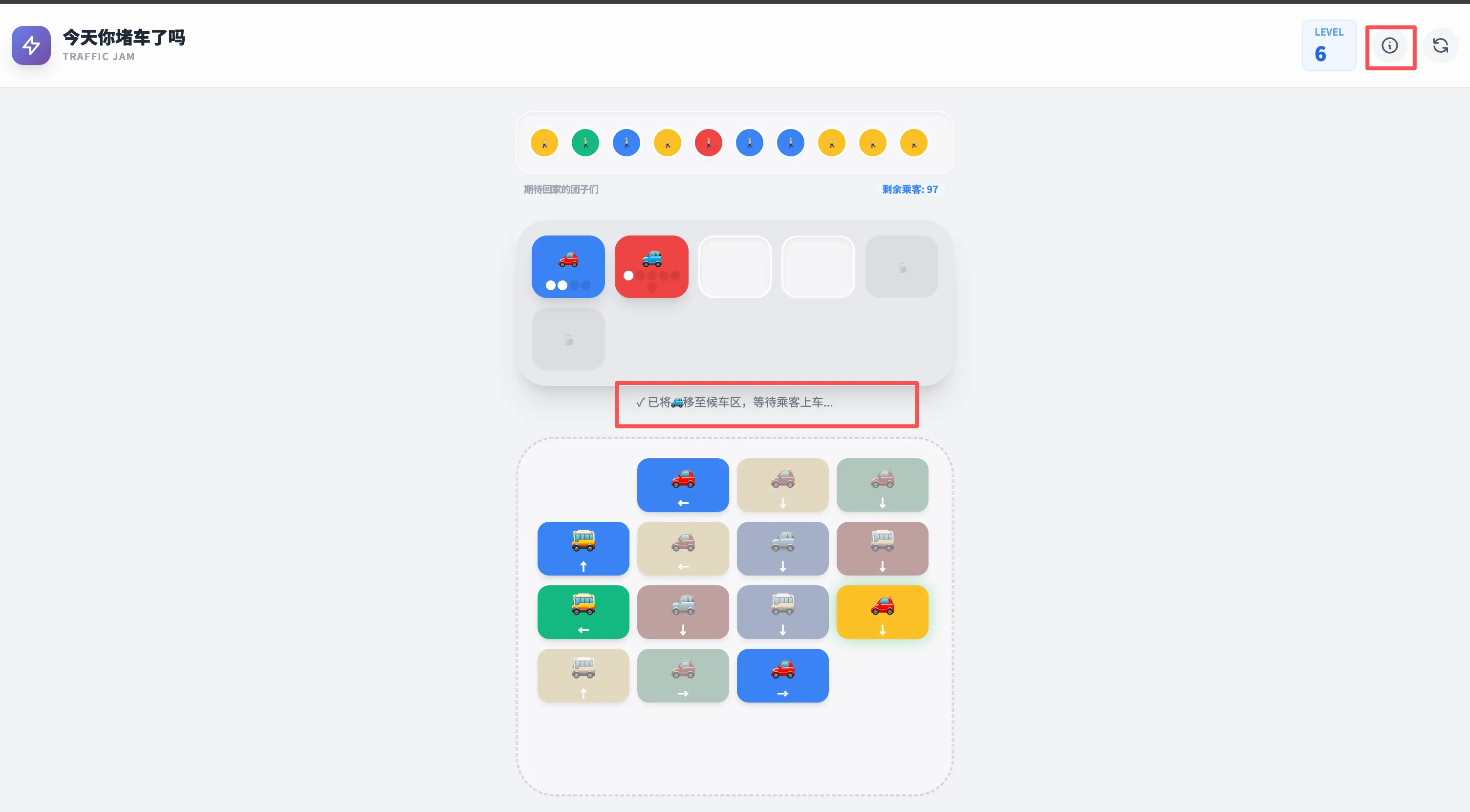

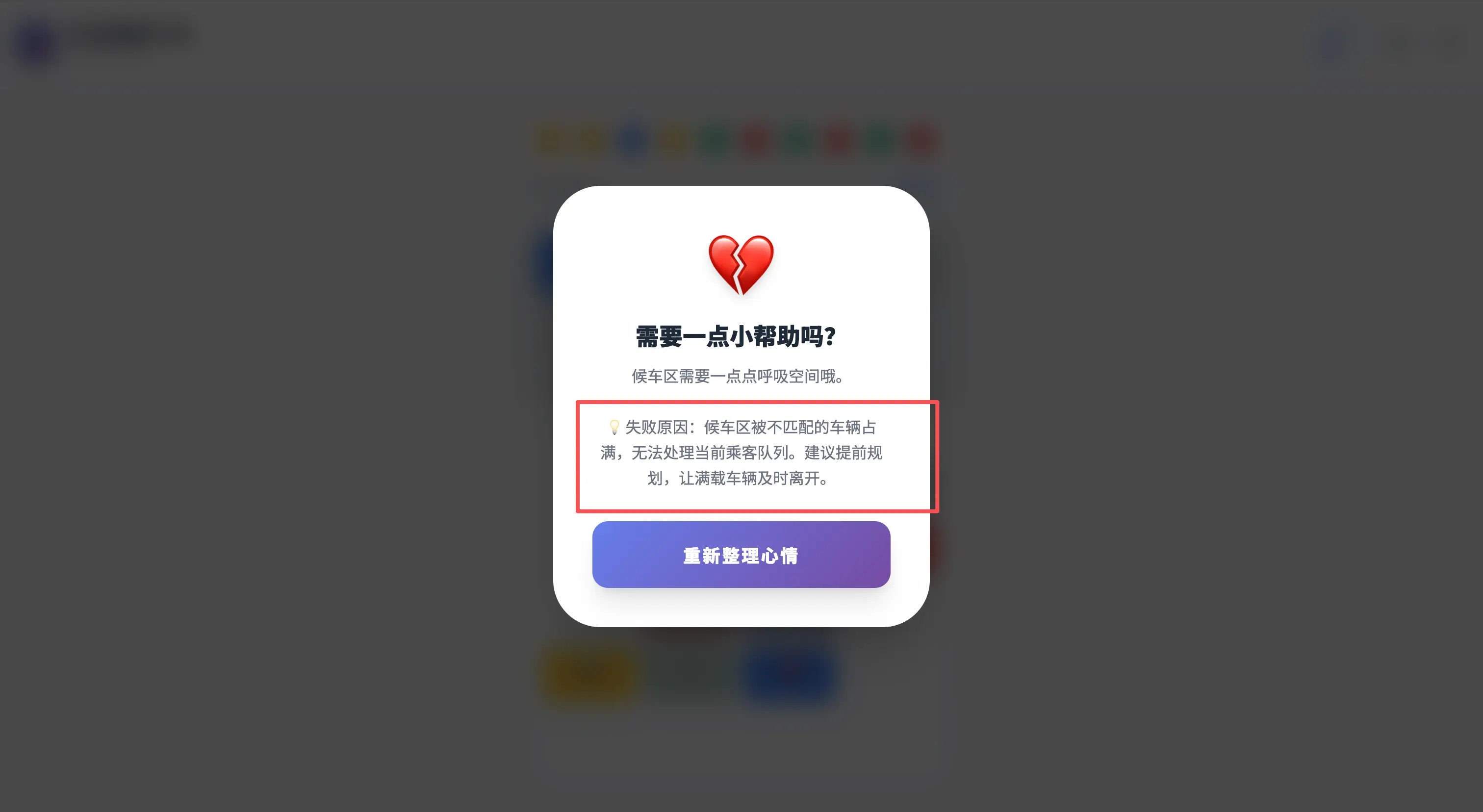

这是用 AI 基于以上建议改进后的一些过程和效果

从上面可以看到,加了一些提示和失败前的预警,还加了游戏说明,体验比我的第一版简单游戏交互好多了,这些让我一点点加,可能有时一下想不出来,交给 AI 先做一些设计的优化,再去调整,不仅可以补齐我对界面交互的短板,还可以对产品进行快速迭代优化,感觉对大家可能有点借鉴意义吧。

本文标题:使用 AI 优化界面交互

文章作者:Canace

发布时间:2026-01-18

最后更新:2026-02-24

原始链接:https://canace.site/ai-optimize-ui/

版权声明:转载请注明出处

分享